腾讯开源最大MoE大模型-Hunyuan-Large

腾讯开源最大MoE大模型-Hunyuan-Large

Sunway鹅厂迫于压力真是把家底都掏出来,自家最好的大模型开源了

- 就是元宝、微信读书、QQ音乐里的同款模型 Hunyuan Moe A52B

- 389B 的 MoE 模型

- 激活参数 52 B

- 256K 上下文

- 7T 训练量

- 免费,可商用

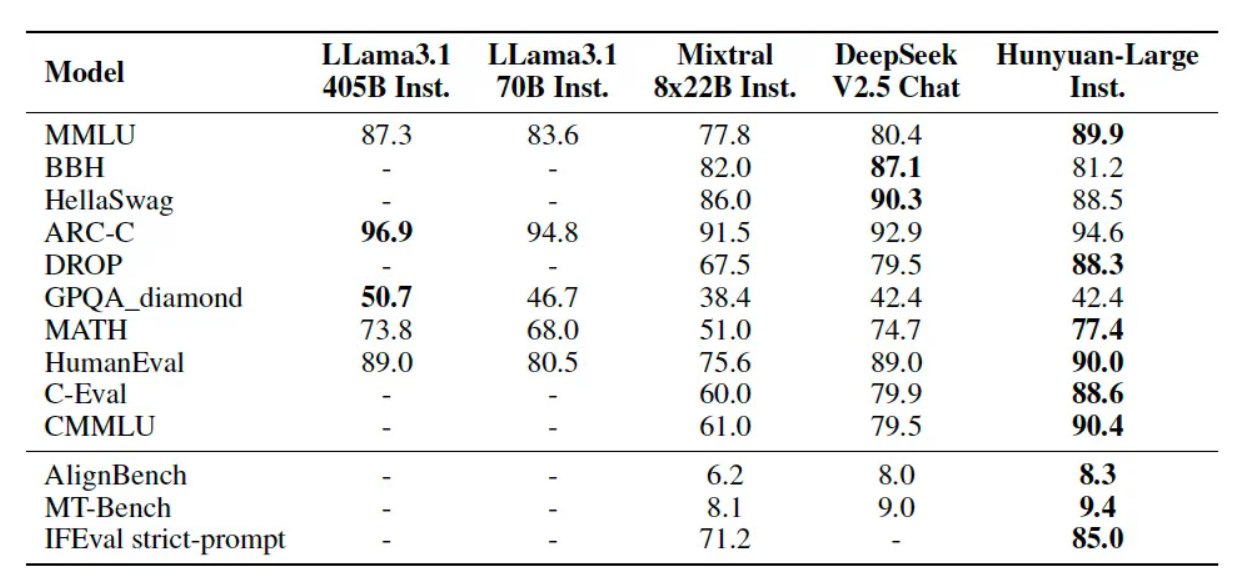

指标都非常好

把 MoE 的技术心得全部公开了…对就是文生图这个也开了

Hunyuan-Large 整体模型效果

公开测评结果显示,腾讯混元 Large 在 CMMLU、MMLU、CEval、MATH 等多学科综合评测集以及中英文 NLP 任务、代码和数学等 9 大维度全面领先,超过 Llama3.1、Mixtral 等一流的开源大模型。

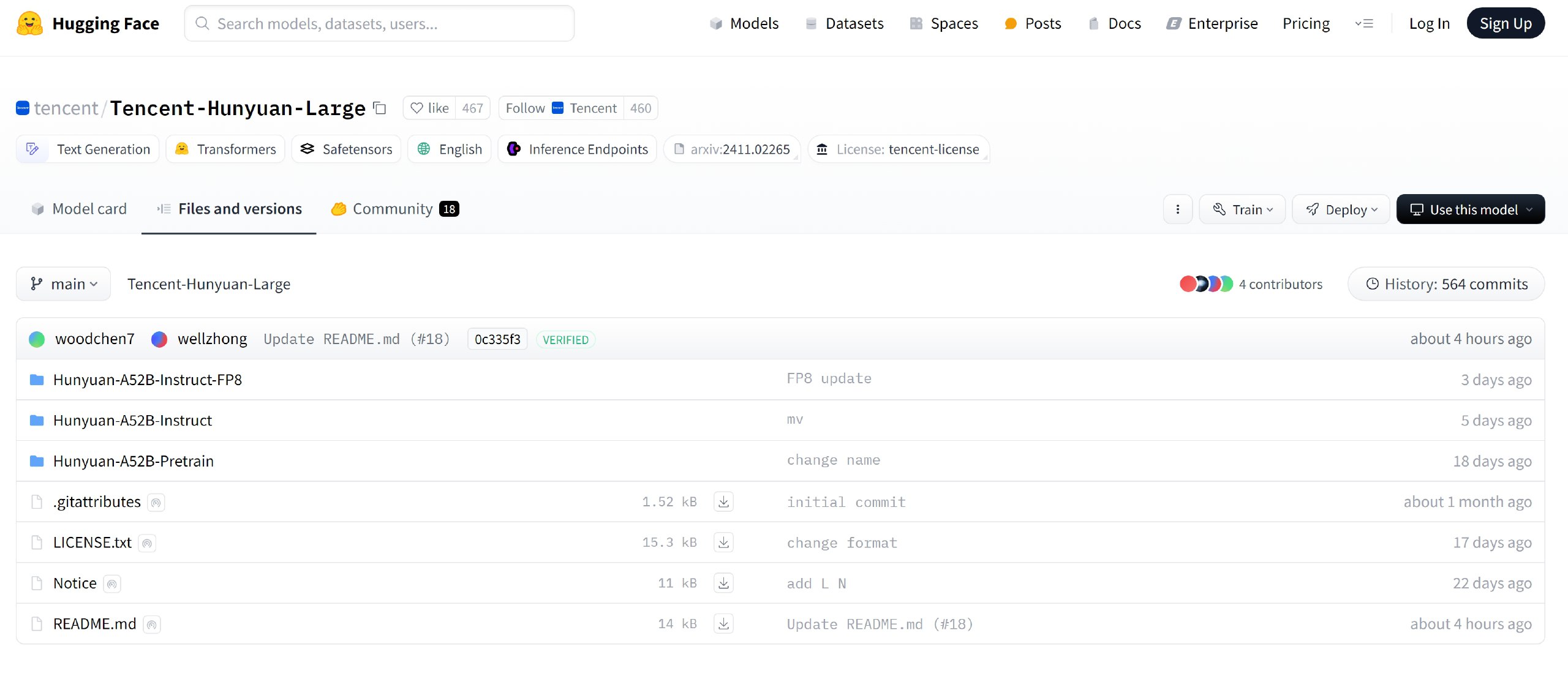

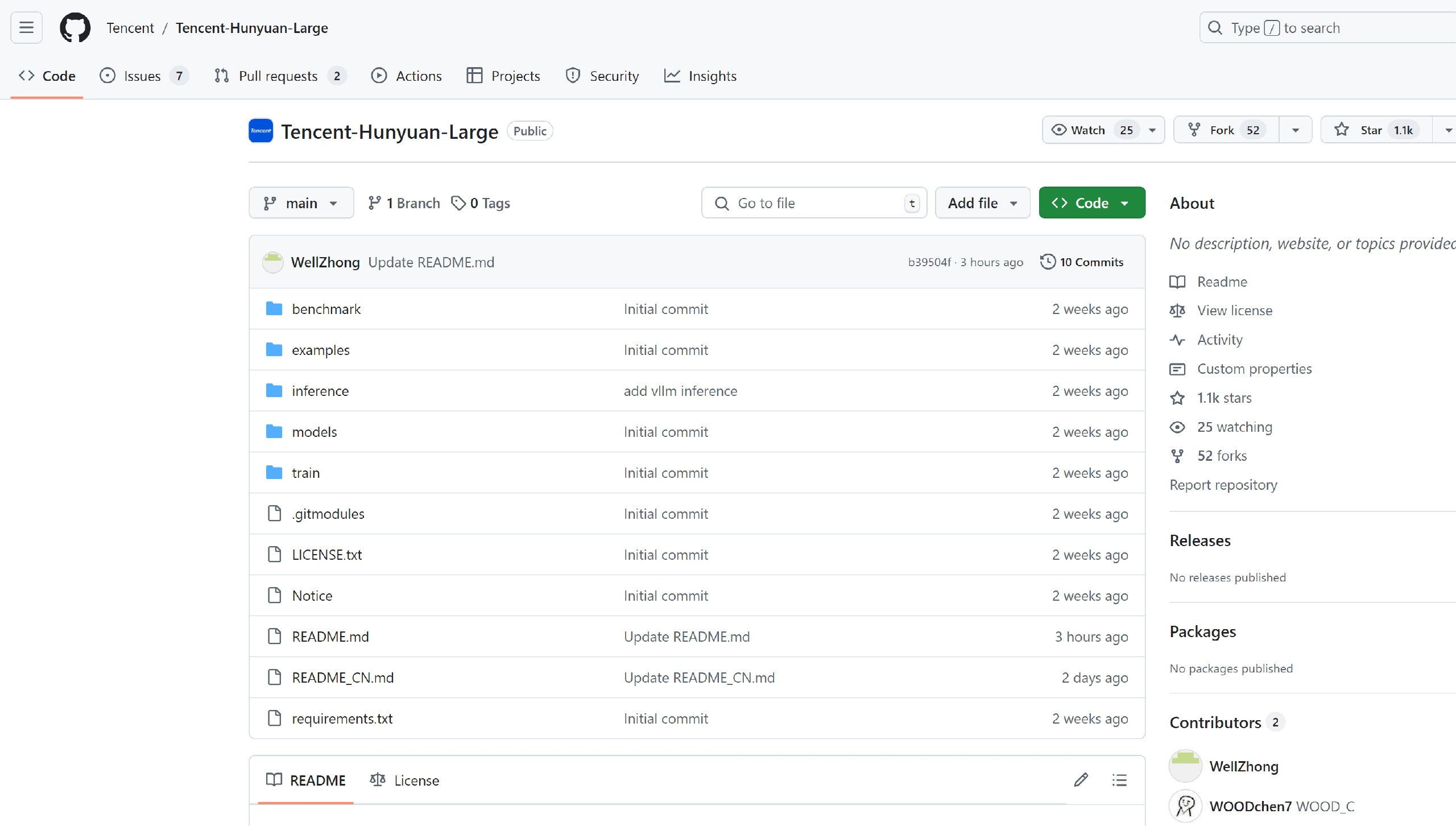

本次腾讯混元 - Large 共计开源三款模型:Hunyuan-A52B-Pretrain,Hunyuan-A52B-Instruct 和 Hunyuan-A52B-FP8,可支持企业及开发者精调、部署等不同场景的使用需求,可在 HuggingFace、Github 等技术社区直接下载,免费可商用。通过技术优化,腾讯混元 Large 适配开源框架的精调和部署,具有较强的实用性。腾讯云 TI 平台和高性能应用服务 HAI 也同步开放接入,为模型的精调、API 调用及私有化部署提供一站式服务。

【开源官网】:https://llm.hunyuan.tencent.com/

【腾讯3D模型访问地址官网地址】:https://3d.hunyuan.tencent.com

【github(开源模型工具包)】:https://github.com/Tencent/Hunyuan-Large

【huggingface(模型下载)】:https://huggingface.co/tencent/Hunyuan-Large/tree/main

【huggingface demo 地址】:https://huggingface.co/spaces/tencent/Hunyuan-Large

【技术报告】:https://arxiv.org/abs/2411.02265